Изучаем термины: энтропия

Содержание:

- Весьма школьный пример

- Энтропия растет. Энтропия растёт в изолированных системах?

- Так что же такое энтропия?

- Энтропия: тезисно и на примерах

- Энтропия философия.

- Энтропия. Что такое энтропия?

- Энтропия в биологии. Энтропия (значения)

- Примечания

- Большие числа превращают вероятность в закон

- Интересные факты

- Виды энтропии

- Происхождение

- Информационный подход в философии

Весьма школьный пример

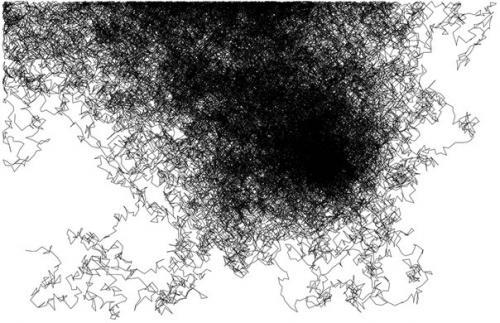

В любой момент времени вы будете видеть случайный снимок трех молекул. Есть восемь разных путей организовать молекулы, но только два из них (ЛЛЛ, ППП) разместят все три молекулы в одной части контейнера. Это всего лишь 25 % вероятности. В остальное время атомы, скорее всего, будут распределены равномерно. И равномерное распределение — это более высокое состояние энтропии, чем концентрированное.

Вы можете играть в эту же игру, набрав полную ладонь монет и подбрасывая их в воздух. Орел и решка — это правая и левая часть коробки, и наоборот. Проделайте этот жест несколько раз и увидите, что молекулы почти всегда равномерно распределяются.

Энтропия растет. Энтропия растёт в изолированных системах?

Пять мифов о развитии и энтропии. Миф третий.Храним мы под замком надёжным деньги, продукты прячем от тепла во льду.Но человеку жить в уединенье и взаперти совсем невмоготу.Второе начало термодинамики утверждает, что энтропия в изолированной системе не убывает, то есть сохраняется или растёт. А может ли она расти вне изолированной системы?Сразу заметим, что термин «система» в формулировке второго начала используется лишь для краткости. Под ним понимается любое множество элементов, тогда как система включает связи между ними и предполагает некоторую целостность. И связи, и целостность могут лишь замедлять рост энтропии, исключая некоторые (возможно, нежелательные для системы) состояния. Ни в каких других отношениях системность для второго начала не важна.Требование изолированности возникает из-за того, что из открытой системы энтропия может экспортироваться и рассеиваться в окружающей среде. Но, после того, как изолированное множество элементов уравновесилось, пришло в наиболее вероятное макросостояние, энтропия, достигнув максимума, далее расти не может.Рост энтропии возможен лишь при наличии какой-либо неравновесности, которая не возникнет, пока не возобновится приток энергии извне или отток её наружу. Недаром мы помещаем вещи в изолированные хранилища – это препятствует внешним воздействиям, способствующим возникновению неравновесности и дальнейшему росту энтропии. Поэтому изолированность, как и системность, не способствует росту энтропии, а лишь гарантирует её неубывание. Именно вне изолированной системы, в открытой среде, преимущественно и происходит рост энтропии.Хотя классическая формулировка второго начала не говорит, как изменяется энтропия в открытых системах и средах, это не является большой проблемой. Достаточно мысленно отделить участок среды или группу открытых систем, участвующих в процессе и не испытывающих внешних воздействий и считать их единой изолированной системой. Тогда их суммарная энтропия не должна убывать. Так рассуждали, к примеру, У. Эшби, оценивая воздействие одной системы на другую, и И. Пригожин при рассмотрении диссипативных структур.Хуже то, что большой класс процессов, в которых энтропия растёт, а именно процессов накопления нарушений в системах под влиянием внешних сил, как бы выходит из-под действия второго начала – ведь они не могут идти в изолированных системах!Поэтому лучше было бы сформулировать закон так: любой самопроизвольный процесс преобразования энергии, массы, информации не уменьшает общей энтропии всех связанных с ним систем и частей среды. В такой формулировке снимается избыточное требование системности, изолированность обеспечивается учётом всех участвующих в процессе элементов и утверждается справедливость закона для всех самопроизвольных процессов.

Так что же такое энтропия?

Если в двух словах, то

Например, если вы спросите меня, где я живу, и я отвечу: в России, то моя энтропия для вас будет высока, всё-таки Россия большая страна. Если же я назову вам свой почтовый индекс: 603081, то моя энтропия для вас понизится, поскольку вы получите больше информации.

Почтовый индекс содержит шесть цифр, то есть я дал вам шесть символов информации. Энтропия вашего знания обо мне понизилась приблизительно на 6 символов. (На самом деле, не совсем, потому что некоторые индексы отвечают большему количеству адресов, а некоторые — меньшему, но мы этим пренебрежём).

Или рассмотрим другой пример. Пусть у меня есть десять игральных костей (шестигранных), и выбросив их, я вам сообщаю, что их сумма равна 30. Зная только это, вы не можете сказать, какие конкретно цифры на каждой из костей — вам не хватает информации. Эти конкретные цифры на костях в статистической физике называют микросостояниями, а общую сумму (30 в нашем случае) — макросостоянием. Существует 2 930 455 микросостояний, которые отвечают сумме равной 30. Так что энтропия этого макросостояния равна приблизительно 6,5 символам (половинка появляется из-за того, что при нумерации микросостояний по порядку в седьмом разряде вам доступны не все цифры, а только 0, 1 и 2).

А что если бы я вам сказал, что сумма равна 59? Для этого макросостояния существует всего 10 возможных микросостояний, так что его энтропия равна всего лишь одному символу. Как видите, разные макросостояния имеют разные энтропии.

Пусть теперь я вам скажу, что сумма первых пяти костей 13, а сумма остальных пяти — 17, так что общая сумма снова 30. У вас, однако, в этом случае имеется больше информации, поэтому энтропия системы для вас должна упасть. И, действительно, 13 на пяти костях можно получить 420-ю разными способами, а 17 — 780-ю, то есть полное число микросостояний составит всего лишь 420х780 = 327 600. Энтропия такой системы приблизительно на один символ меньше, чем в первом примере.

Мы измеряем энтропию как количество символов, необходимых для записи числа микросостояний. Математически это количество определяется как логарифм, поэтому обозначив энтропию символом S, а число микросостояний символом Ω, мы можем записать:

S = log Ω

Это есть ничто иное как формула Больцмана (с точностью до множителя k, который зависит от выбранных единиц измерения) для энтропии. Если макросостоянию отвечают одно микросостояние, его энтропия по этой формуле равна нулю. Если у вас есть две системы, то полная энтропия равна сумме энтропий каждой из этих систем, потому что log(AB) = log A + log B.

Людвиг Больцман

Из приведённого выше описания становится понятно, почему не следует думать об энтропии как о собственном свойстве системы. У системы есть определённые внутренняя энергия, импульс, заряд, но у неё нет определённой энтропии: энтропия десяти костей зависит от того, известна вам только их полная сумма, или также и частные суммы пятёрок костей.

Другими словами, энтропия — это то, как мы описываем систему. И это делает её сильно отличной от других величин, с которыми принято работать в физике.

Энтропия: тезисно и на примерах

Чем больше способов реализации, тем больше информационная неопределённость.

Пример 1. Программа Т9. Если в слове будет небольшое количество опечаток, то программа легко распознает слово и предложит его замену. Чем больше опечаток, тем меньше информации о вводимом слове будет у программы. Следовательно, увеличение беспорядка приведёт к увеличению информационной неопределённости и наоборот, чем больше информации, тем меньше неопределённость.

Пример 2. Игральные кости. Выкинуть комбинацию 12 или 2 можно только одним способом: 1 плюс 1 или 6 плюс 6. А максимальным числом способов реализуется число 7 (имеет 6 возможных комбинаций). Непредсказуемость реализации числа семь самая большая в этом случае.

В общем смысле энтропию (S) можно понимать как меру распределения энергии. При низком значении S энергия сконцентрирована, а при высоком — распределена хаотично.

Пример. Н2О (всем известная вода) в своём жидком агрегатном состоянии будет обладать большей энтропией, чем в твёрдом (лёд). Потому что в кристаллическом твёрдом теле каждый атом занимает определённое положение в кристаллической решётке (порядок), а в жидком состоянии у атомов определённых закреплённых положений нет (беспорядок). То есть тело с более жёсткой упорядоченностью атомов имеет более низкое значение энтропии (S). Белый алмаз без примесей обладает самым низким значением S по сравнению с другими кристаллами.

Связь между информацией и неопределённостью.

Пример 1. Молекула находится в сосуде, который имеет левую и правую часть. Если неизвестно, в какой части сосуда находится молекула, то энтропия (S) будет определяться по формуле S = S max = k * lgW, где k -число способов реализации, W- количество частей сосуда. Информация в этом случае будет равна нулю I = I min =0. Если же точно известно, в какой части сосуда находится молекула, то S = S min =k*ln1=0, а I = I max= log 2 W. Следовательно, чем больше информации, тем ниже значение информационной неопределённости.

Пример 1. Молекула находится в сосуде, который имеет левую и правую часть. Если неизвестно, в какой части сосуда находится молекула, то энтропия (S) будет определяться по формуле S = S max = k * lgW, где k -число способов реализации, W- количество частей сосуда. Информация в этом случае будет равна нулю I = I min =0. Если же точно известно, в какой части сосуда находится молекула, то S = S min =k*ln1=0, а I = I max= log 2 W. Следовательно, чем больше информации, тем ниже значение информационной неопределённости.

Пример 2. Чем выше порядок на рабочем столе, тем больше информации можно узнать о вещах, которые на нём находятся. В этом случае упорядоченность предметов снижает энтропию системы «рабочий стол».

Пример 3. Информация о классе больше на уроке, чем на перемене. Энтропия на уроке ниже, так как ученики сидят упорядочено (больше информации о местоположении каждого ученика). А на перемене расположение учеников меняется хаотично, что повышает их энтропию.

Химические реакции и изменение энтропии.

Пример. При реакции щелочного металла с водой выделяется водород. Водород-это газ. Так как молекулы газа движутся хаотично и имеют высокую энтропию, то рассматриваемая реакция происходит с увеличением её значения. То есть энтропия химической системы станет выше.

Энтропия философия.

ЭНТРОПИЯ (от греч. entropia – поворот, превращение) – часть внутренней энергии замкнутой системы или энергетической совокупности Вселенной, которая не может быть использована, в частности не может перейти или быть преобразована в механическую работу. Точное определение энтропии производится с помощью математических расчетов. Наиболее отчетливо эффект энтропии виден на примере термодинамических процессов. Так, тепло никогда совершенно не переходит в механическую работу, преобразуясь в др. виды энергии. Примечательно, что при обратимых процессах величина энтропии остается неизменной, при необратимых, наоборот, неуклонно возрастает, причем этот прирост происходит за счет уменьшения механической энергии. Следовательно, все то множество необратимых процессов, которые происходят в природе, сопровождается уменьшением механической энергии, что в конечном итоге должно привести к всеобщему параличу, или, говоря иначе, «тепловой смерти». Но такой вывод правомочен лишь в случае постулирования тоталитарности Вселенной как замкнутой эмпирической данности. Христ. теологи, основываясь на энтропии, говорили о конечности мира, используя ее как доказательство существования Бога.

Энтропия. Что такое энтропия?

Героиня фильма Вуди Аллена Whatever Works дает такое определение энтропии: это из-за чего тяжело засунуть обратно в тюбик зубную пасту. Она еще интересно объясняет принцип неопределенности Гейзенберга, еще один повод посмотреть фильм.

Энтропия — это мера беспорядка, хаоса. Вы пригласили друзей на новогоднюю вечеринку, прибрались, помыли пол, разложили на столе закуску, расставили напитки. Одним словом, все упорядочили и устранили столько хаоса, сколько смогли. Это система с маленькой энтропией

Энтропия — это мера беспорядка, хаоса. Вы пригласили друзей на новогоднюю вечеринку, прибрались, помыли пол, разложили на столе закуску, расставили напитки. Одним словом, все упорядочили и устранили столько хаоса, сколько смогли. Это система с маленькой энтропией

Что такое энтропия простыми словами: определение, в каких областях используется этот термин. Понятные примеры энтропии в жизни. https://science.ru-land.com/stati/chto-takoe-singulyarnost

Вы все, наверное, представляете, что происходит с квартирой, если вечеринка удалась: полный хаос. Зато у вас утром есть в распоряжении система с большой энтропией.

Для того, чтобы привести квартиру в порядок, надо прибраться, то есть потратить на это много энергии. Энтропия системы уменьшилась, но никакого противоречия со вторым началом термодинамики нет — вы же добавили энергию извне, и эта система уже не изолированная.

Один из вариантов конца света — тепловая смерть вселенной вследствие второго начала термодинамики. Энтропия вселенной достигнет своего максимума и ничего в ней больше происходить не будет.

В общем случае звучит все довольно уныло: в природе все упорядоченные вещи стремятся к разрушению, к хаосу. Но откуда тогда на Земле жизнь? Все живые организмы невероятно сложные и упорядоченные и каким-то образом всю свою жизнь борются с энтропией (хотя в конце концов она всегда побеждает.

Все очень просто. Живые организмы в процессе жизнедеятельности перераспределяют энтропию вокруг себя, то есть отдают свою энтропию всему, чему только могут. Например, когда мы едим бутерброд, то красивый упорядоченный хлеб с маслом мы превращаем известно во что. Получается, что свою энтропию мы отдали бутерброду, а в общей системе энтропия не уменьшилась.

А если взять землю в целом, то она вообще не является замкнутой системой: солнце снабжает нас энергией на борьбу с энтропией.

Энтропия в биологии. Энтропия (значения)

Энтропи́я :

- Энтропия — мера необратимого рассеивания энергии, мера отклонения реального процесса от идеального.

- Термодинамическая энтропия — функция состояния термодинамической системы

- Энтропия Вселенной

- Энтропия (биология) — в биологической экологии единица измерения биологической вариативности .

- Информационная энтропия — мера хаотичности информации, неопределённость появления какого-либо символа первичного алфавита.

- Энтропия — децентрализованная компьютерная сеть коммуникаций peer-to-peer, разработанная с целью быть стойкой к сетевой цензуре.

- Топологическая энтропия

- Метрическая энтропия

- Энтропия динамической системы

- Дифференциальная энтропия

- Энтропия языка — статистическая функция текста на определённом языке, либо самого языка, определяющая количество информации на единицу текста.

- Энтропия (журнал) — международный междисциплинарный журнал на английском языке об исследованиях энтропии и информации.

- « Энтропия » — художественный фильм Марии Саакян 2012 года.

- Энтропия (настольная игра) ( англ. Entropy ) — настольная игра 1977 года от Eric Solomon и 1994 года от Августина Каррено.

Примечания

- Зубарев Д. Н., Морозов В. Г. // Физическая энциклопедия : / Гл. ред. А. М. Прохоров. — М.: Советская энциклопедия (т. 1—2); Большая Российская энциклопедия (т. 3—5), 1988—1999. — ISBN 5-85270-034-7.

- Сивухин Д. В. Общий курс физики. — М., 1979. — Т. II. Термодинамика и молекулярная физика. — С. 127.

- , с. 77.

- Зубарев Д. Н., Морозов В. Г. // Физическая энциклопедия : / Гл. ред. А. М. Прохоров. — М.: Советская энциклопедия (т. 1—2); Большая Российская энциклопедия (т. 3—5), 1988—1999. — ISBN 5-85270-034-7.

- Энтропия // : / гл. ред. А. М. Прохоров. — 3-е изд. — М. : Советская энциклопедия, 1969—1978.

- , с. 468—475.

- , с. 13—22, 108-125.

- Джейнс Э. Т. О логическом обосновании методов максимальной энтропии // ТИИЭР. — 1982. — Т. 70, вып. 9. — С. 33—51.

- , с. 29—39.

Большие числа превращают вероятность в закон

Если вы увеличите число молекул воздуха, к примеру, до 1026 или выше, вероятность подсказывает, что случайные движения в итоге распределят молекулы «равномерно». Благодаря квантовой механике, случайность становится принципиальной составляющей всего этого. То есть, поскольку есть техническая вероятность того, что все молекулы воздуха внезапно покинут вашу спальню, пока вы спите, за несколько минут, это явно не то, чего стоит бояться ночью.

Растущая энтропия — на самом деле закон, поскольку во Вселенной так много частиц, что вероятность того, что все они спонтанно выстроятся в состояние низкой энтропии, ошеломляюще мала. Этот же тип случайно работает в отношении азартных игр и прогнозирования погоды.

Ну или еще пример. Вам выпадает решка два раза подряд, и вы совсем не удивляетесь этому. Но если кому-то решка выпадает сто раз кряду, это становится подозрительным. Чтобы оценить масштаб такого события, представьте себе: если вы будете подбрасывать монетку 10 раз в секунду, у вас уйдет времени в триллион раз больше нынешнего возраста вселенной, прежде чем вы дождетесь результата. Грубо говоря, в определенный момент система становится настолько большой, что шанс на то, что энтропия будет уменьшаться, не просто мал, но крайне близок к нулю. Поэтому мы называем это «вторым законом».

Креационисты среди вас могут использовать это как доказательство, что сложные вещи (вроде людей или динозавров) никогда не смогли бы сформироваться. В конце концов, вы ведь высоко упорядоченный человек, стоит полагать. Если вы облако газа, примите мои извинения. Но если предположить, что вы человек, нет ничего странного в том, что вы существуете как маленький шанс высокого порядка.

Суть правила в том, что энтропия растет во всей вселенной. Например, если вы сделаете хорошенький холодильник, полный холодного воздуха, вы сделаете это за счет высокой энтропии горячего воздуха. Вот почему кондиционер нуждается в выхлопе, а обогреватель — нет. По этой же причине вы не можете построить вечный двигатель. Часть энергии всегда будет преобразовываться в тепло.

Энтропия непрерывно увеличивается со временем. Вы сидите в горячей ванне в прохладной комнате, чувствуете себя тепло и уютно, но потом события начинают принимать угрожающий поворот: вода в номере по температуре приближается к воздуху, вам становится холодно, вас атакуют мурашки.

То же самое касается будущего Вселенной. С течением времени тепло равномерно распределится во Вселенной. Звезды выгорят, черные дыры испарятся, станет темно и холодно. Бум.

Интересные факты

- Словом «хаос» называют изначальное состояние Вселенной. В этот момент она представляла собой лишь не имеющую форму совокупность пространства и материи.

- Согласно исследованиям одних ученых, наибольшим источником энтропии являются сверхмассивные черные дыры. Но другие считают, что благодаря мощным гравитационным силам, притягивающим все к массивному телу, мера хаоса передается в окружающее пространство в незначительном количестве.

- Интересно то, что жизнь и эволюция человека направлены в противоположную сторону от хаоса. Ученые утверждают, что это возможно из-за того, что на протяжении своей жизни человек, как и другие живые организмы, принимает на себя меньшее значение энтропии, нежели отдает в окружающую среду.

Виды энтропии

Области применения:

- физическая химия;

- экономические науки;

- статистическая физика или информационная теория;

- социологическая наука.

Рассмотрим подробнее виды энтропии в каждой из областей ее применения.

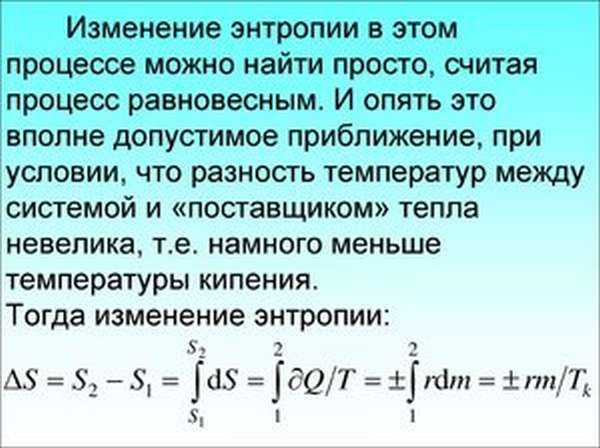

В термодинамике

В термодинамике (физической химии) энтропия – это та степень, в которой реальный процесс отклоняется от идеального. Основной постулат термодинамики, сформулированный физиками на базе изучения энтропии: каждая система термодинамики, которая изолирована от внешнего мира, постепенно становится равновесной и впоследствии не имеет возможности выйти самостоятельно из состояния равновесия. Беспорядок – основная характеристика состояния любой системы. Из него она стремится к равновесию.

Возникает вопрос: с помощью чего определить степень беспорядка?

Основной метод: каждому возможному состоянию системы присваивается число вариантных комбинаций, которыми это состояние может быть реализовано.

Вывод: чем больше число вариантов, тем больше величина энтропии. Чем больше организованности в структуре вещества, тем меньше его неупорядоченность.

Абсолютная величина энтропии равна приращению имеющейся в системе тепловой энергии в условиях теплопередачи при заданной температуре.

Клазиус определял энтропию как совокупность приведенных тепловых энергий, как функцию состояния системы, которое остается неизменным в условиях замкнутости, а в условиях открытых необратимых процессов – оно всегда положительно изменяется. Ее значение отражает связь между макро- и микросостояниями. Это единственная функциональная величина, показывающая направленность процессов. Но она не показывает сам процесс перехода состояний из одного в другое, а находится лишь исходным и итоговым состоянием системы.

В экономике

Коэффициент энтропии дает возможность проанализировать уровень концентрации рынка и его изменение. Чем этот коэффициент ниже, тем меньше неопределенность внешней среды, что ведет к повышению вероятности возникновения монополий. Этот показатель выступает в качестве косвенного помощника в оценивании выигрыша, который получает предприятие в ходе ведения монополистической деятельности или в условиях изменения рыночной концентрации (влияет на число потенциальных конкурентов фирмы).

В информатике или статистической физике

Информационная энтропия – это степень непредсказуемости информационной системы. Этот показатель служит для определения степени хаотичности эксперимента, который проводится или произошедшего события. Значение хаотичности прямопропорционально числу состояний, нахождение системы в которых возможно. Все действия, направленные на упорядочивание системы, ведут к появлению информационных сведений о ней и снижают информационную неопределенность, которая выявляет пропускную способность информационного канала, обеспечивающую надежность и достоверность передачи информационных данных. Это позволяет прогнозировать частично возможный ход эксперимента, т.е. предсказывать вероятность того или иного события.

Пример: расшифровка закодированного текста. Для этого анализируется вероятность возникновения того или иного символа и высчитывается величина их энтропии.

В социологии

Энтропия – показатель, характеризующий отклонение общественной системы или ее составных частей от заданного (образцового) состояния. Проявления этого отклонения:

- уменьшение эффективности общественного развития и жизнедеятельности общества как целостной системы;

- снижение способности к самоорганизации.

Пример: персонал организации настолько загружен бумажной работой (составлением отчетов, ведением документации), что не может успевать выполнять свои должностные функции и обязанности (осуществление аудита). Мера неэффективного использования трудовых ресурсов собственником предприятия – это информационная неопределенность.

Происхождение

Впервые понятие «отрицательной энтропии» предложил в 1943 году австрийский физик Эрвин Шрёдингер в популярной книге «Что такое жизнь?». В ней он пытался продолжить идеи своего коллеги Нильса Бора о глубокой связи физических и философских законов, согласно которым сформулированный Нильсом Бором принцип дополнительности мог объединить общечеловеческие знания до простого понимания единства мира.

В своей работе Шрёдингер пишет:

| Во-первых, я хотел бы заметить, что устанавливая значение этого термина (физического), я должен начать обсуждение с термина «свободной энергии». Это — более точное понятие в этом контексте. Но этот чисто технический термин оказывается лингвистически очень близким к общему понятию энергии для среднего читателя, который пытается разобраться в разнице между этими двумя терминами. |

Позже американский физик Леон Бриллюэн в своей работе «Научная неопределенность и информация» сократил термин «отрицательная энтропия» до слова негэнтропия и ввел его в таком виде при помощи негэнтропийного принципа информации в теорию информации.Эрвин Шрёдингер объясняет, как живая система экспортирует энтропию, чтобы поддержать свою собственную энтропию на низком уровне. При помощи термина негэнтропия, он мог выразить свою идею кратко: живая система импортирует негэнтропию для самосохранения:

| Живой организм непрерывно увеличивает свою энтропию, или, иначе, производит положительную энтропию и, таким образом, приближается к опасному состоянию максимальной энтропии, представляющему собой смерть. Он может избежать этого состояния, то есть оставаться живым, только постоянно извлекая из окружающей его среды отрицательную энтропию. Отрицательная энтропия — это то, чем организм питается. Или, чтобы выразить это менее парадоксально, существенно в метаболизме то, что организму удается освобождаться от всей той энтропии, которую он вынужден производить, пока жив. |

В простом понимании, энтропия — хаос, саморазрушение и саморазложение. Соответственно, негэнтропия — движение к упорядочиванию, к организации системы. По отношению к живым системам: для того, чтобы не погибнуть, живая система борется с окружающим хаосом путём организации и упорядочивания последнего, то есть импортируя негэнтропию. Таким образом объясняется поведение самоорганизующихся систем.

Синонимы

Альберт Сент-Дьёрди предложил заменить термин негэнтропия на синтропия, термин, впервые предложенный в 1940 году итальянским математиком Луиджи Фантаппие (англ.)русск., который пытался в своей теории объединить биологический и физический мир.

В литературе о самоорганизующихся системах для описания этого процесса также используются термины экстропия и эктропия

Информационный подход в философии

Негэнтропия с точки зрения «информационного подхода» — антоним от понятия энтропии, то есть понятие, «генетически» из неё вырастающее. Поэтому негэнтропия может рассматриваться только с опорой на энтропию, то есть параллельно.

Как известно, понятие энтропии было введено Клаузиусом (1859) в термодинамике. Затем астрофизики заговорили о «Тепловой смерти вселенной», — вывод об этом следовал из второго закона термодинамики и предположения о замкнутости Вселенной, как термодинамической системы.

Философы не могли не обратить внимания на объясняющую силу понятия энтропии, которая выражалась в возможности рассматривать все процессы, происходящие в мире как энтропические в термодинамическом смысле, в том числе процессы, связанные с человеческой деятельностью в организации социальной жизни. Например, Н. Бердяев в статье «Воля к жизни и воля к культуре» (1923 г.), писал:

| Рождается напряжённая воля к самой „жизни“, к практике „жизни“, к могуществу „жизни“, к наслаждению „жизнью“, к господству над „жизнью“. И эта слишком напряжённая воля к „жизни“ губит культуру, несёт с собой смерть культуры… Происходит социальная энтропия, рассеяние творческой энергии культуры. |

Его современник Н. О. Лосский в статье «Материя в системе органического мировоззрения» (1923 г.) уже использует понятия энтропии и эктропии (ссылаясь на статью физика Ф. Ауэрбаха «Эктропизм или физическая теория жизни») в отстаивании философской точки зрения, согласно которой «материя производна от высшего бытия, способного также производить другие виды действительности, кроме материи». На этом основании Лосский считает, что «закон энтропии следовало бы формулировать с ограничением, именно с указанием, что он имеет значение лишь для безжизненной среды», поскольку жизнь противодействует возрастанию энтропии. Лосский писал: «Достигается эктропизм тем, что живой организм превращает хаотические движения в упорядоченные, имеющие определённое направление». Таким образом, понятия «энтропия» и «эктропия» (в современном звучании — негэнтропия) использовались в философии в термодинамическом контексте. Что касается биологии, то термодинамический теоретический аппарат «органически» вписался в энергетику живого в виде «всеобщего закона биологии» (Бауэр, 1935), а определение живого Э. Либберт сформулировал в таком виде:

| Живыми называются такие системы, которые способны самостоятельно поддерживать и увеличивать свою очень высокую степень упорядоченности в среде с меньшей степенью упорядоченности. Такие процессы являются процессами с отрицательной энтропией (негэнтропийными процессами). |

В «Математической теории связи» (1948) К. Шеннон предложил формулу вида:

- H(x)=−∑i=1npilog2pi,{\displaystyle H(x)=-\sum _{i=1}^{n}p_{i}\log _{2}p_{i},}

где pi{\displaystyle p_{i}} — вероятность i{\displaystyle i}—го независимого случайного события из набора n{\displaystyle n} возможных состояний. Её называют «энтропией дискретного источника информации» или «энтропией конечного ансамбля» (В. И. Дмитриев) (см. статью Информационная энтропия). То, что скрывается за этой формулой, относящейся к «мере свободы чьего-либо (или какой-либо системы) выбора в выделении сообщения» (по Грэхэму), совпадало с точностью до умножения на константу с математическим описанием энтропии термодинамической системы, предложенной Больцманом:

- H=−1Mn∑i=1NmilnmiMn.{\displaystyle H=-{1 \over M_{n}}\sum _{i=1}^{N}m_{i}\ln {m_{i} \over M_{n}}.}

Л. Р. Грэхэм отмечал:

| Некоторые учёные считали возможные применения этого совпадения огромными. Возможность какой-либо аналогии или даже структурного совпадения энтропии и информации вызвало оживлённые обсуждения среди физиков, философов и инженеров многих стран. |

Как проходили дискуссии в СССР по этим вопросам, Лорен Р. Грэхэм достаточно полно описал в своей книге «Естествознание, философия и науки о человеческом поведении в Советском Союзе». В конце VIII главы свой книги Грэхэм отметил, что ожидание концептуального прорыва на стыке термодинамической и информационной энтропий не оправдалось, а «спад интереса во всём мире к кибернетике как концептуальной схеме пришёлся как раз на то время, когда компьютеры стали крайне необходимыми для деловой, промышленной и военной деятельности». (1991 г.).